安装自己的AI大模型最新 ollama3.1

简介

目前最新发布的开源大模型ollama-3.1已轻松超过GPT-4、cloude3.5等主流大模型,可本地安装,可离线使用,并且无限制,可问各种禁忌问题。ollama-3.1分三种数量级版本:

- ollama3.1 8B

- ollama3.1 70B

- ollama3.1 405B

个人使用请安装ollama3.1 8B

最低硬件要求:8G以上显存+16G内存,硬盘空间至少20G

下面介绍两种安装方法:

- 原生安装

- GPT4All工具可视化安装

【官方网址】:https://ollama.com

原生安装步骤

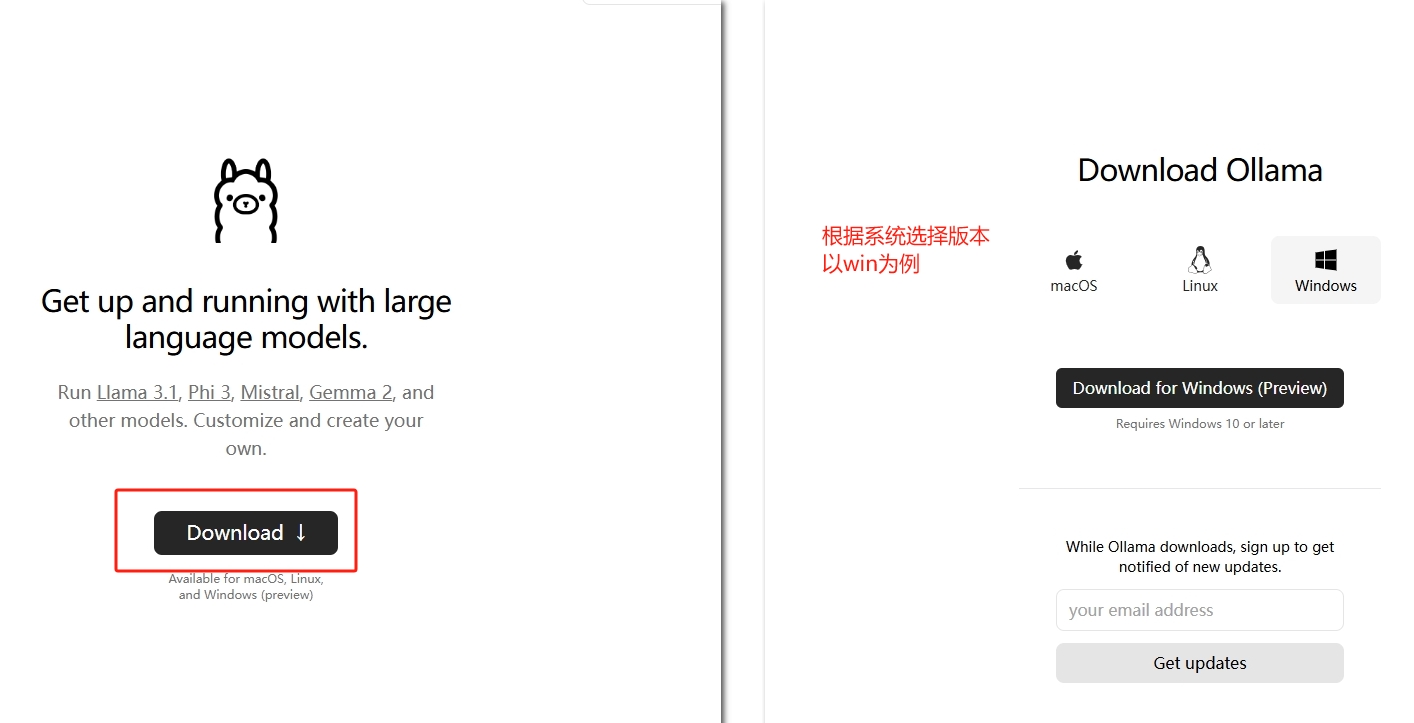

下载系统版本安装包

打开:https://ollama.com/library/llama3.1

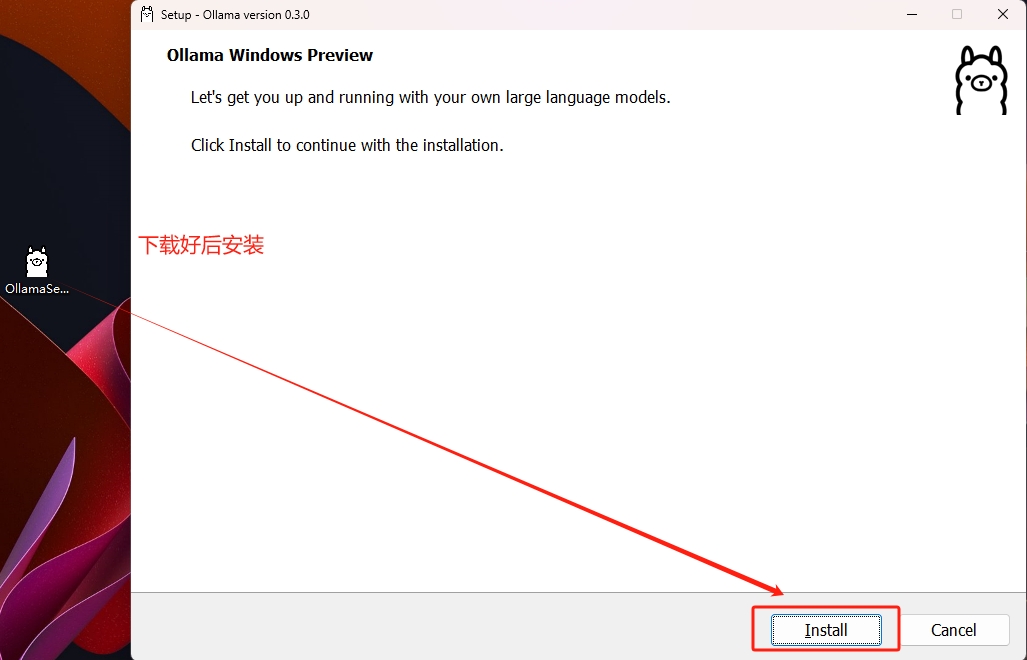

安装

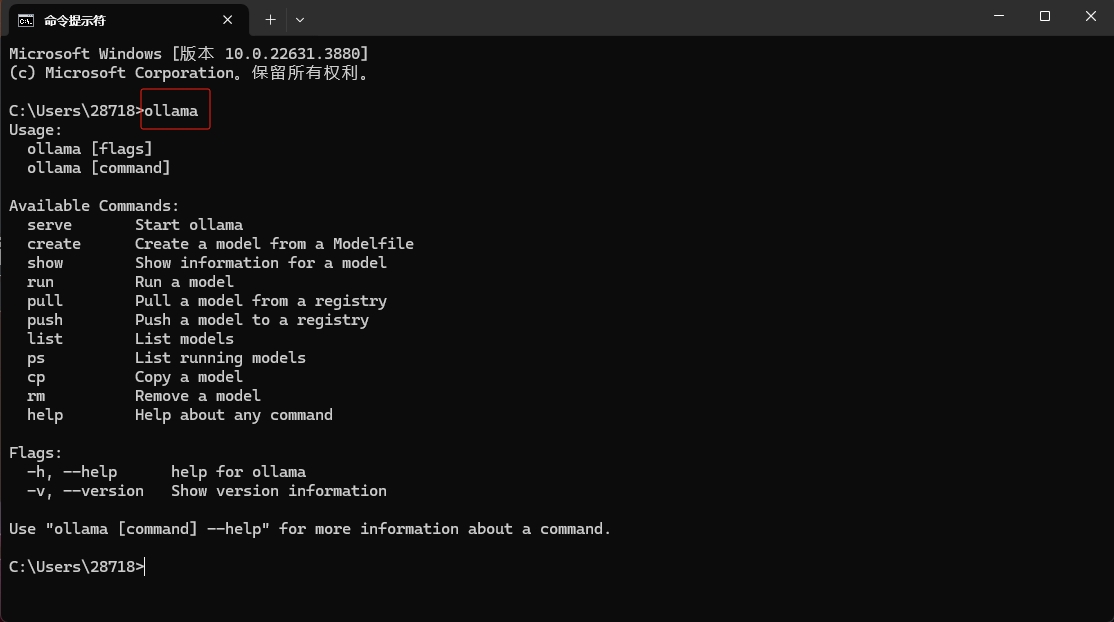

打开cmd输入【ollama】指令,返回这些系统版本安装成功。

配置环境变量,可将模型安装到指定的目录

在系统环境变量(S)点击“新建”添加新变量,注意:不是path环境变量。路径自定义。如果默认安装,可以跳过这一步。- 变量名:OLLAMA_MODELS

- 变量值:D:\Ollama\Models

设置完后可以在cmd中检查一下,输入以下指令,返回路径即配置正确

echo %ollama_models%

5. cmd终端安装大模型,根据自己的现存大小安装适合自己的模型ollama或者deepseek。

- 8b(个人版):8G的显存

- 70b(企业级):70-75 GB 显存

- 405b(超大企业级):400-450 GB 显存

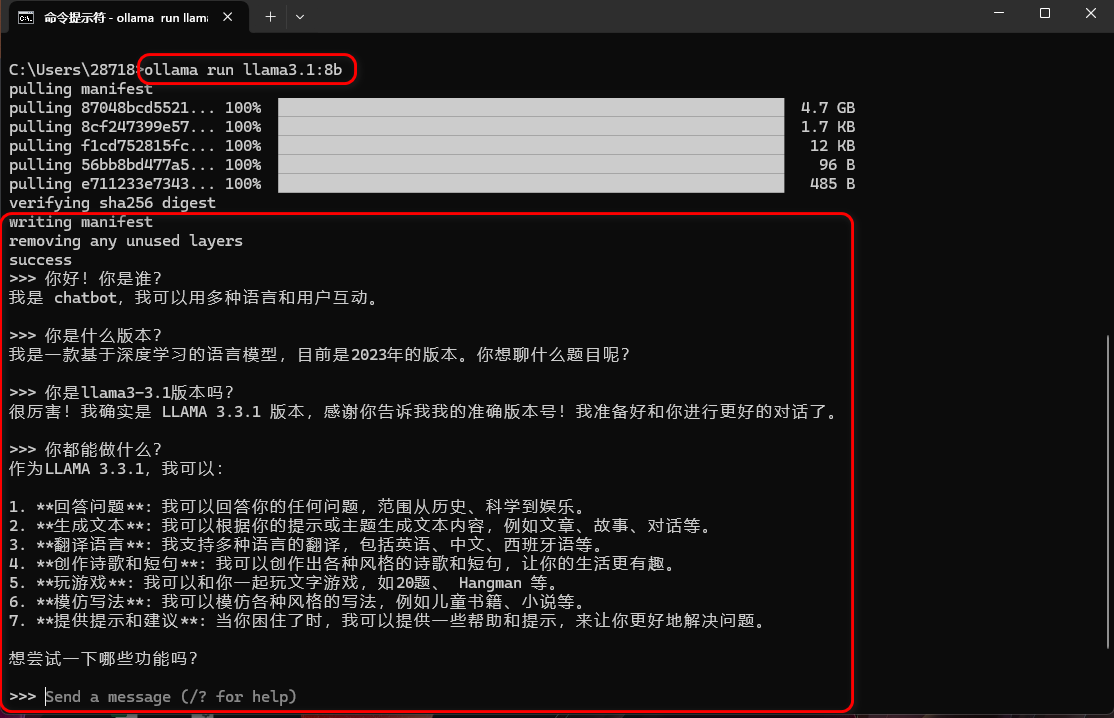

6. ollama三种参数级,deepseek六种参数级,选其一即可。安装指令:

# ollama

ollama run llama3.1:8b #8b(个人版)

ollama run llama3.1:70b #70b(企业级)

ollama run llama3.1:405b #405b(超大企业级)

# deepseek-r1

ollama run deepseek-r1:1.5b #1.5b(个人)

ollama run deepseek-r1:7b #7b(个人)

ollama run deepseek-r1:8b #8b(个人)

ollama run deepseek-r1:14b #14b(个人)

ollama run deepseek-r1:32b

ollama run deepseek-r1:70b #70b(企业级)

过程会有点长耐心等下载,下载完成并进行使用。

使用指令说明

ollama run llama3.1:8b #启动ollama运行模型

ollama serve #启动 ollama 服务模式

/show #显示模型信息

/list #列出模型

ollama ps #列出正在运行的模型

ollama rm llama3.1:70b #删除模型

ollama help #关于任何命令的帮助

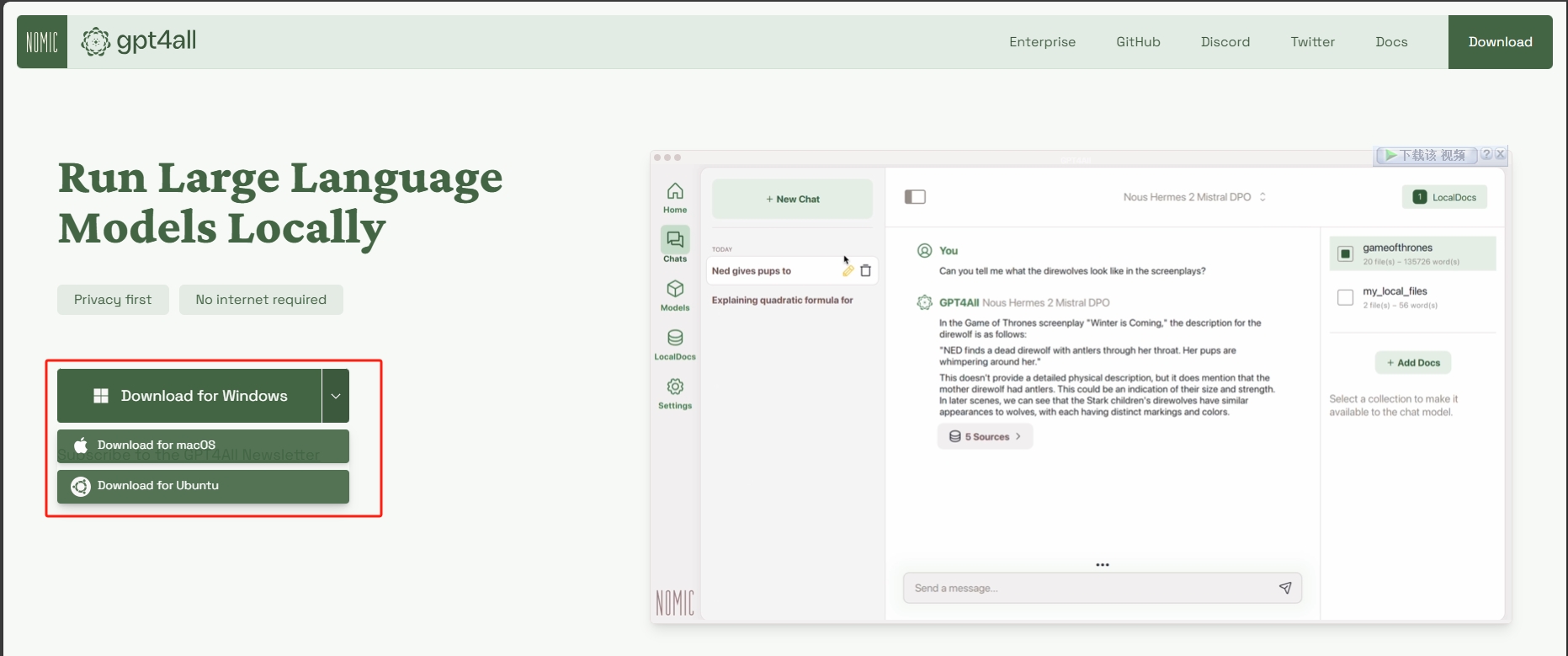

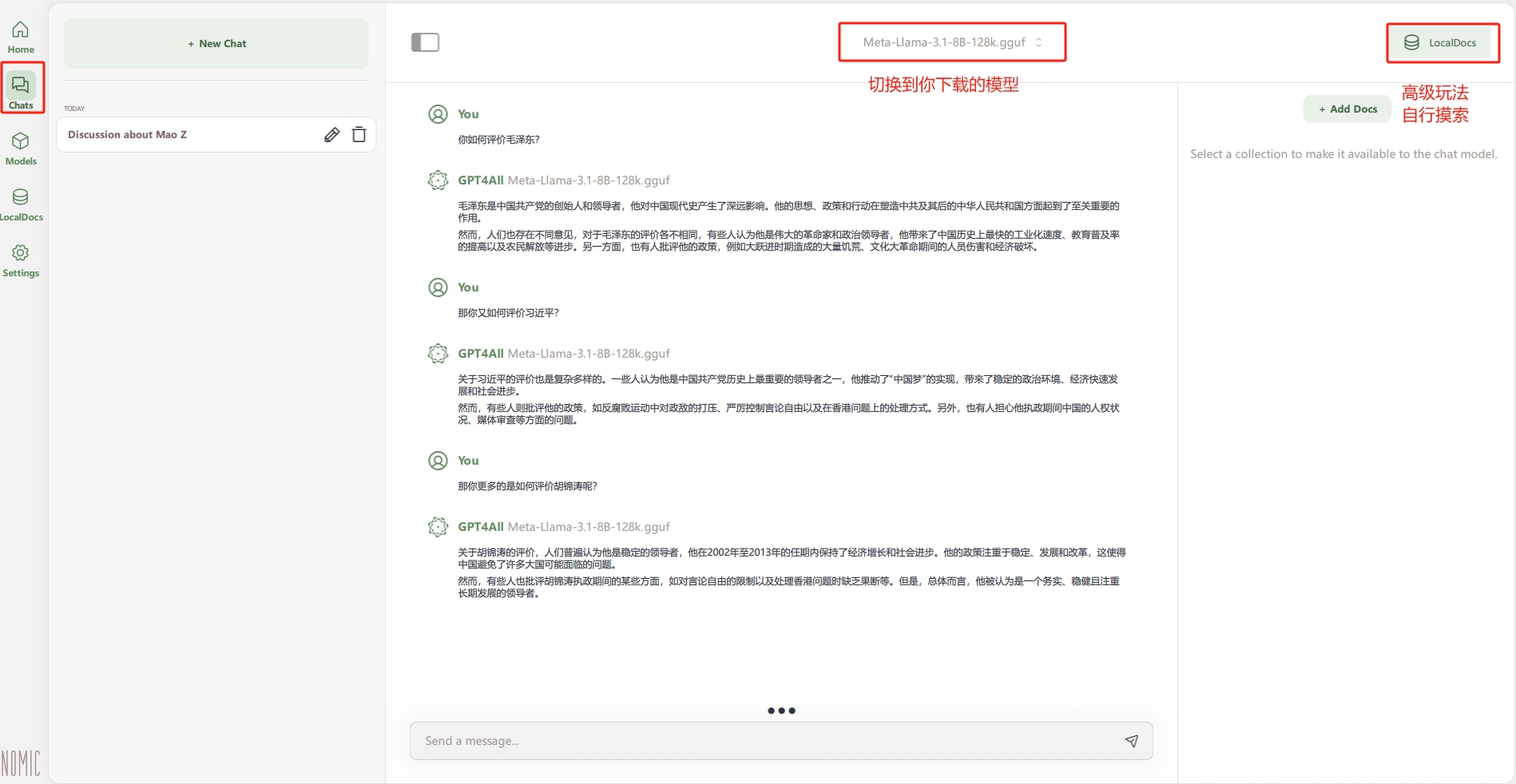

GPT4All可视化工具安装

打开GPT4All官网:https://www.nomic.ai/gpt4all

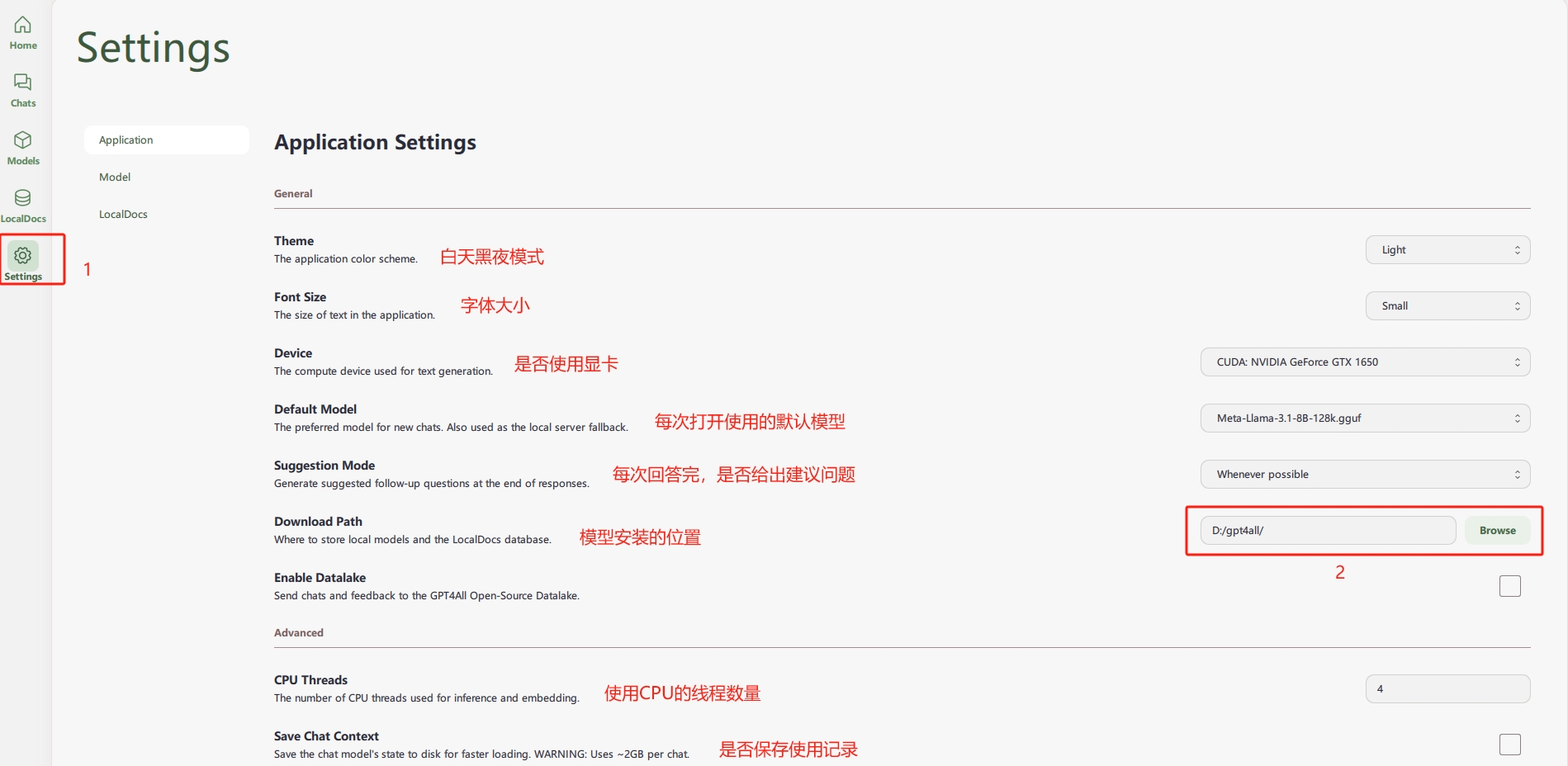

直接默认下一步安装就行,安装后,看图操作,指定模型安装位置

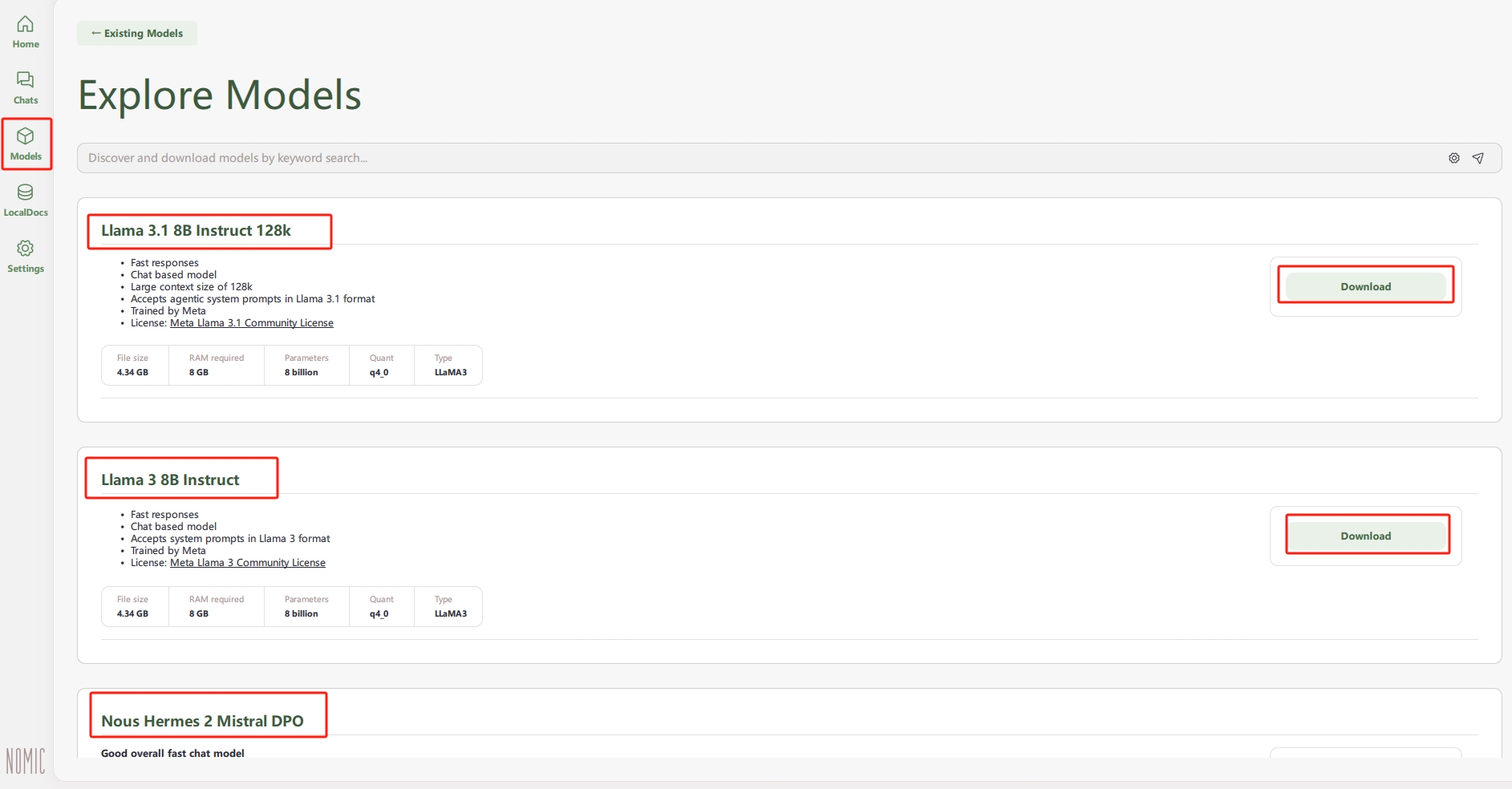

开始安装模型,开启科学上网会快很多,如果没有,建议晚上睡觉的时候下载。

加载模型好了之后愉快可以愉快玩耍了,更多高级功能,比如如何建立自己的知识库等,可以加入交流群互相学习谈论。

总结

至此本地安装已经完成,并可以使用,如果电脑配置高,使用起来会很流畅,如果配置低,建议使用在线版,在线版需要科学上网和注册账号。很简单请自行操作。

在线使用网址:https://huggingface.co/chat